Ceph چیست و معماری آن چگونه است؟ مقایسه Ceph با سایر سیستمهای ذخیره سازی

حجم دادهها با سرعتی سرسامآور در حال افزایش است و نیاز به سیستمهای ذخیرهسازی توزیعشده، مقاوم و مقیاسپذیر بیش از هر زمان دیگری احساس میشود. Ceph بهعنوان یکی از قدرتمندترین راهکارهای متنباز در حوزه ذخیرهسازی ابری، توانسته با بهرهگیری از معماری توزیعشده و حذف نقاط شکست واحد (Single Point of Failure)، زیرساختی پایدار و انعطافپذیر برای مدیریت داده در مقیاس کلان ایجاد کند.

Ceph چیست؟

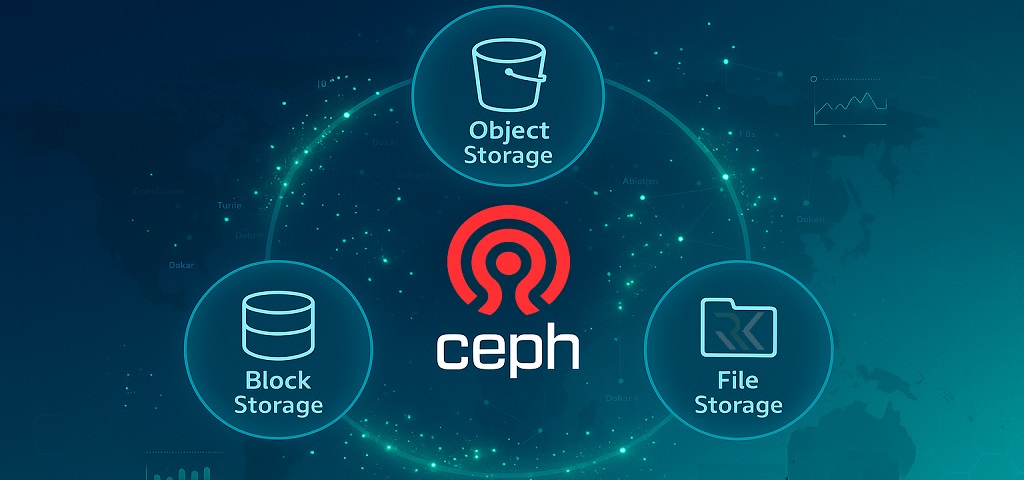

Ceph یک سیستم ذخیرهسازی توزیعشده (Distributed Storage System) متنباز است که برای فراهمسازی سه نوع سرویس ذخیرهسازی — Object Storage، Block Storage و File System — در قالب یک بستر یکپارچه طراحی شده است. این پروژه ابتدا توسط Sage Weil در دانشگاه Wisconsin آغاز شد و بعدها با حمایت شرکتهای بزرگی مانند Red Hat و Community Ceph Foundation به یکی از ستونهای اصلی زیرساختهای ابری تبدیل گردید.

در مقایسه با سیستمهای ذخیرهسازی سنتی، Ceph بر مبنای فلسفهی «خودترمیمی و خودمدیریتی» طراحی شده است؛ یعنی در صورت بروز خطا یا از دست رفتن یک نود، خوشه بهصورت خودکار دادهها را بازسازی میکند و عملکرد سیستم بدون توقف ادامه مییابد. همین ویژگیها باعث شده Ceph به گزینهای محبوب برای پیادهسازی زیرساختهای ابری عظیم مانند OpenStack، Proxmox VE، Kubernetes و پلتفرمهای دیتاسنتر سازمانی تبدیل شود.

معماری و نحوه عملکرد Ceph

معماری Ceph بر اساس مفهوم خوشهی توزیعشده و بدون نقطه شکست (Fault-Tolerant Cluster) طراحی شده است؛ هر جزء از سیستم بهصورت مستقل عمل میکند اما در هماهنگی کامل با سایر اجزا قرار دارد. این ساختار ماژولار موجب میشود Ceph نهتنها مقیاسپذیر و پایدار باشد، بلکه بتواند در محیطهای کلانداده، مجازیسازی و ابری بهصورت پویا گسترش یابد.

نقش MON (Monitor) در حفظ هماهنگی خوشه

سرویس Monitor (MON) ستون فقرات هماهنگی در خوشهی Ceph است. این سرویس وظیفه دارد وضعیت نودها، تغییرات پیکربندی، نقشهی CRUSH و سلامت کلی سیستم را کنترل کند. MONها معمولاً بهصورت چندگانه (حداقل سه عدد) راهاندازی میشوند تا از طریق رأیگیری اکثریت (quorum) تصمیمگیریهای مطمئن درباره وضعیت خوشه انجام شود. در واقع MON همان مغز مدیریتی Ceph است که یکپارچگی و صحت ارتباط بین همه اجزا را تضمین میکند.

نقش OSD (Object Storage Daemon) در ذخیرهسازی دادهها

ماژولهای OSD مهمترین بخش عملیاتی Ceph هستند و مسئول ذخیرهسازی واقعی دادهها، تکرار (replication) و بازیابی خودکار در صورت خرابی نود میباشند. هر دیسک فیزیکی معمولاً یک OSD را میزبانی میکند که با سایر OSDها در تعامل است تا دادهها را طبق نقشهی CRUSH توزیع کند. تعداد زیاد OSDها یعنی ظرفیت بالا، افزونگی بیشتر و پایداری خوشه. عملکرد OSD مبتنی بر RADOS است و عملیات خواندننوشتن را با حداقل تأخیر و حداکثر تحمل خطا انجام میدهد.

بخش MDS (Metadata Server) و عملکرد آن در CephFS

سرویس Metadata Server (MDS) در Ceph زمانی کاربرد دارد که از CephFS (سیستم فایل توزیعشده Ceph) استفاده میکنیم. این سرویس مسئول مدیریت اطلاعات مربوط به ساختار فایلها، دسترسیها و مجوزها است، نه خود دادهها. MDS باعث میشود کاربران بتوانند مانند یک فایلسیستم معمولی با فایلها کار کنند، اما دادهها در پسزمینه روی OSDها ذخیره شوند. این جداسازی بین داده و متادیتا موجب افزایش کارایی در خواندن و جستوجوی فایلهای بزرگ است.

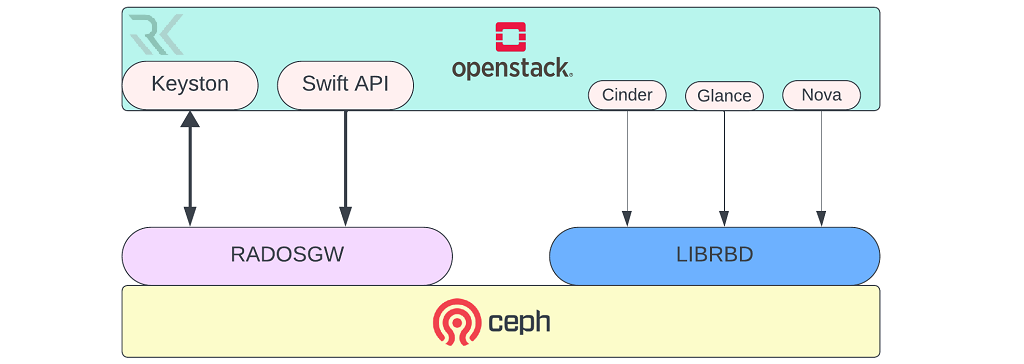

Gateway و رابطهای دسترسی (RADOS Gateway, librados)

برای دسترسی به دادهها و سرویسهای Ceph، رابطهای خاصی بهنام RADOS Gateway (RGW) و کتابخانهی librados بهکار میروند. RGW معمولاً بهعنوان یک درگاه مبتنی بر پروتکلهای S3 و Swift عمل میکند تا برنامهها و کاربران بتوانند با Ceph بهشیوهی RESTful ارتباط برقرار کنند. در مقابل librados به توسعهدهندگان اجازه میدهد مستقیماً با لایهی توزیعشدهی RADOS تعامل داشته باشند.

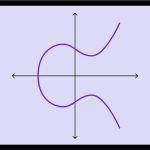

مفهوم CRUSH Map و الگوریتم توزیع دادهها

الگوریتم CRUSH Map قلب توزیع داده در Ceph است. برخلاف سیستمهای سنتی که از جدولهای مرکزی برای مکانیابی داده استفاده میکنند، CRUSH با بهرهگیری از توابع ریاضی، محل قرارگیری داده را بهصورت توزیعشده محاسبه میکند. این روش موجب حذف وابستگی به کنترلکننده مرکزی، افزایش سرعت بازیابی و توزیع دادهها میشود.

ارتباط Ceph با ماشینهای مجازی (Integration با Proxmox، OpenStack و Kubernetes)

Ceph بهطور طبیعی با پلتفرمهای مجازیسازی و ابری نظیر Proxmox VE، OpenStack و Kubernetes یکپارچه میشود. از طریق RBD (RADOS Block Device) و Ceph CSI میتوان دیسکهای مجازی، حجمهای پایدار (Persistent Volumes) و Storage Pools را بهصورت خودکار ایجاد و مدیریت کرد. این ادغام باعث میشود ماشینهای مجازی و کانتینرها مستقیماً از خوشهی Ceph تغذیه شوند، در نتیجه پایداری و سرعت دسترسی به دادهها در زیرساختهای ابری به بالاترین سطح ممکن برسد.

مقایسه Ceph با سایر سیستمهای ذخیرهسازی

Ceph |

ZFS |

GlusterFS |

VMware vSAN |

|

|---|---|---|---|---|

|

نوع معماری |

توزیعشده |

فایلمحور |

توزیعشده |

مبتنی بر هایپروایزر |

|

افزونگی داده |

بومی (Replication / Erasure Coding) |

مبتنی بر RAID |

Replica-based |

بومی و خودکار |

|

مقیاسپذیری |

بسیار بالا |

محدود به نودهای محلی |

متوسط |

بسیار بالا |

|

سطح دسترسی به داده |

Object / Block / File |

فقط File |

File |

Block |

|

پایداری و تحمل خطا |

بسیار بالا؛ خودترمیمی خوشه |

وابسته به سختافزار و RAID |

توسط؛ وابسته به replication |

لا؛ کنترلشده توسط هایپروایزر |

|

هزینه لایسنس |

رایگان و متنباز |

رایگان و متنباز |

رایگان |

بالا |

|

پیادهسازی در Cloud / |

عالی؛ یکپارچه با OpenStack، Kubernetes، Proxmox |

ضعیف؛ نیاز به افزونهه |

متوسط؛ یکپارچگی محدود |

محدود به زیرساخت VMware |

|

پشتیبانی از چند نوع ذخیرهسازی |

دارد (Object, Block, File) |

ندارد |

ندارد |

فقط Block |

|

مدیریت و مانیتورینگ |

پیشرفته (Ceph Dashboard, CLI) |

مقدماتی |

ساده (CLI) |

پیشرفته |

نصب و راهاندازی Ceph در لینوکس

در این بخش، فرآیند نصب و پیکربندی Ceph بر روی لینوکس را بهصورت کاملاً عملی و گامبهگام توضیح میدهیم. این آموزش مبتنی بر توزیعهای Ubuntu / Debian است، اما برای RHEL / CentOS / Rocky Linux نیز مشابه عمل میکند.

1. بررسی پیشنیازهای سختافزاری و سیستم

قبل از هر چیز باید از فعال بودن تنظیمات زیر مطمئن شوید:

- حداقل ۳ Node برای اجرای MON و OSD

- هر Node دارای حداقل 4 GB RAM و یک دیسک اختصاصی برای OSD

- فعال بودن دسترسی شبکه بین Nodeها و تنظیم hostname یکتا

- همگام بودن ساعت سیستمها با NTP

بررسی ارتباط SSH بدون رمز:

ssh ceph-node2 'hostname'

2. بهروزرسانی بستهها و نصب پیشنیازها

ابتدا سیستم را آپدیت کرده و ابزارهای ضروری را نصب کنید:

sudo apt update && sudo apt -y upgrade

sudo apt install -y ssh ceph ceph-mgr ceph-mon ceph-osd ceph-mds ceph-common

در توزیعهای RHEL / Rocky Linux:

sudo dnf install -y ceph ceph-mon ceph-mgr ceph-osd ceph-mds ceph-common

3. ایجاد کاربر و تنظیم دسترسی SSH بین نودها

برای مدیریت مرکزی Ceph نیاز به ارتباط امن بین Nodeها داریم:

sudo useradd -m -s /bin/bash cephadmin

sudo passwd cephadmin

sudo visudo

در فایل sudoers اضافه کنید:

cephadmin ALL=(ALL) NOPASSWD:ALL

سپس کلید SSH را ایجاد و توزیع کنید:

su - cephadmin

ssh-keygen

ssh-copy-id ceph-node2

ssh-copy-id ceph-node3

4. راهاندازی اولیه خوشه Ceph

در گره اصلی (node1) خوشه را اولیهسازی و MON را فعال کنید:

sudo cephadm bootstrap --mon-ip 192.168.1.10

پس از پایان، داشبورد وب Ceph در پورت 8443 فعال خواهد بود. آدرس ورود:

https://192.168.1.10:8443

5. افزودن گرههای جدید به خوشه

با استفاده از cephadm گرههای دیگر را اضافه کنید:

sudo cephadm add-host ceph-node2 --addr 192.168.1.11

sudo cephadm add-host ceph-node3 --addr 192.168.1.12

سپس سرویس OSD را روی هر نود مستقر کنید:

sudo cephadm shell -- ceph orch daemon add osd ceph-node2:/dev/sdb

sudo cephadm shell -- ceph orch daemon add osd ceph-node3:/dev/sdb

6. بررسی وضعیت خوشه

پس از فعالسازی همه گرهها، وضعیت خوشه را بررسی کنید:

ceph -s

خروجی صحیح باید شامل وضعیت HEALTH_OK باشد و تعداد MON، MGR و OSDها قابل مشاهده است.

7. راهاندازی و تست CephFS یا RBD

اگر قصد دارید از Ceph بهعنوان Block Storage استفاده کنید:

rbd pool create rbdpool

rbd create rbdpool/testdisk --size 10G

برای فعالسازی CephFS:

ceph fs volume create cephfs

mkdir /mnt/cephfs

mount -t ceph 192.168.1.10:6789:/ /mnt/cephfs -o name=admin,secret=<key>

8. فعالسازی داشبورد و تنظیم رمز عبور

اگر هنگام bootstrap رمز دسترسی تعیین نشده بود، با دستور زیر آن را تنظیم کنید:

ceph dashboard set-login-credentials admin StrongPass123!

سپس از طریق مرورگر به داشبورد مدیریتی خوشه دسترسی پیدا کنید.

جمعبندی…

سیف (Ceph) یک سیستم ذخیرهسازی توزیعشده و متنباز است که با معماری بدون نقطه شکست، تحملپذیری بالا و مقیاسپذیری چشمگیر، بهعنوان ستون فقرات زیرساختهای کلانداده و ابری شناخته میشود. با پشتیبانی از سه نوع دسترسی داده (Object، Block، File)، ادغام با پلتفرمهای ابری مانند OpenStack، Proxmox VE و Kubernetes و مدیریت هوشمند مبتنی بر CRUSH Map، Ceph بهترین انتخاب برای سازمانهایی است که به دنبال ذخیرهسازی مطمئن، انعطافپذیر و مقرونبهصرفه هستند.

سوالات متداول

Ceph یک سیستم ذخیرهسازی توزیعشده متنباز است که دادهها را بهصورت خودکار میان نودهای متعدد توزیع و تکرار میکند، برای تضمین پایداری و افزایش کارایی سیستمهای بزرگ.

Ceph از سرویسهای MON، OSD، MDS، CRUSH Map و RGW تشکیل شده است که هرکدام بخشی از مدیریت و ذخیرهسازی دادهها را برعهده دارند.

Ceph از معماری کاملاً توزیعشده برای Object, Block, File پشتیبانی میکند، در حالی که ZFS و GlusterFS بیشتر در سطح فایل و RAID عمل میکنند.

بله، Ceph بهترین گزینه برای محیطهای ابری است و با پلتفرمهایی مانند OpenStack، Kubernetes و Proxmox یکپارچه میشود.

نصب Ceph به کمک ابزارهایی مانند cephadm بسیار ساده شده و میتوان کل خوشه را با چند فرمان نصب، بوتاسترپ و مدیریت کرد.

حداقل ۳ نود با 4GB RAM، ارتباط شبکه پایدار و یک دیسک مجزا برای OSD کفایت میکند تا نسخه عملیاتی پایه پیادهسازی شود.

بله، Ceph از رمزنگاری در سطح دیسک و ارتباطات شبکه بین نودها پشتیبانی کرده و امنیت دادهها را تضمین میکند.

بله، Ceph بهصورت بومی بر پایه لینوکس اجرا میشود، زیرا هسته آن با ابزارهای و ماژولهای کرنل لینوکس (مثل librados و cephadm) در تعامل مستقیم است.

موارد اخیر

-

احراز هویت بدون رمز عبور چیست و چرا آینده امنیت دیجیتال است؟

احراز هویت بدون رمز عبور چیست و چرا آینده امنیت دیجیتال است؟ -

FIDO چیست و چگونه فرایند احراز هویت را امن تر میکند؟

FIDO چیست و چگونه فرایند احراز هویت را امن تر میکند؟ -

ماژول امنیتی سخت افزاری (HSM) چیست و با Hardware Security Key چه تفاوتی دارد؟

ماژول امنیتی سخت افزاری (HSM) چیست و با Hardware Security Key چه تفاوتی دارد؟ -

کلید سختافزاری چیست؟ معرفی انواع Hardware Security Key

کلید سختافزاری چیست؟ معرفی انواع Hardware Security Key -

OpenVPN چیست و چگونه کار میکند؟ + مقایسه با IPsec VPN

OpenVPN چیست و چگونه کار میکند؟ + مقایسه با IPsec VPN -

WireGuard چیست؟ بررسی امنیت، کاربردها و انواع اتصال

WireGuard چیست؟ بررسی امنیت، کاربردها و انواع اتصال -

رمزنگاری متقارن و رمزنگاری نامتقارن چیست؟ بررسی تفاوتها و کاربردها

رمزنگاری متقارن و رمزنگاری نامتقارن چیست؟ بررسی تفاوتها و کاربردها -

منظور از کلید عمومی و کلید خصوصی در رمزنگاری چیست؟ برسی نحوه عملکرد و مقایسه

منظور از کلید عمومی و کلید خصوصی در رمزنگاری چیست؟ برسی نحوه عملکرد و مقایسه -

رمزنگاری منحنی بیضی ECC چیست و چگونه کار میکند؟ (مرحله به مرحله با مثال)

رمزنگاری منحنی بیضی ECC چیست و چگونه کار میکند؟ (مرحله به مرحله با مثال) -

الگوریتم Diffie‑Hellman چیست و چگونه امنیت ارتباطات را تضمین میکند؟

الگوریتم Diffie‑Hellman چیست و چگونه امنیت ارتباطات را تضمین میکند؟

برترین ها

-

احراز هویت بدون رمز عبور چیست و چرا آینده امنیت دیجیتال است؟

احراز هویت بدون رمز عبور چیست و چرا آینده امنیت دیجیتال است؟ -

FIDO چیست و چگونه فرایند احراز هویت را امن تر میکند؟

FIDO چیست و چگونه فرایند احراز هویت را امن تر میکند؟ -

ماژول امنیتی سخت افزاری (HSM) چیست و با Hardware Security Key چه تفاوتی دارد؟

ماژول امنیتی سخت افزاری (HSM) چیست و با Hardware Security Key چه تفاوتی دارد؟ -

کلید سختافزاری چیست؟ معرفی انواع Hardware Security Key

کلید سختافزاری چیست؟ معرفی انواع Hardware Security Key -

OpenVPN چیست و چگونه کار میکند؟ + مقایسه با IPsec VPN

OpenVPN چیست و چگونه کار میکند؟ + مقایسه با IPsec VPN

اشتراک گذاری این مطلب

دیدگاهتان را بنویسید

نشانی ایمیل شما منتشر نخواهد شد. بخشهای موردنیاز علامتگذاری شدهاند *