Apache Hadoop (هدوپ) چیست و چه کاربردهایی دارد؟ + مقایسه با Apache Spark

آپاچی هدوپ (Apache Hadoop) یک چارچوب متنباز برای ذخیرهسازی و پردازش حجم عظیمی از دادهها بهصورت توزیعشده است. این فناوری با استفاده از مدلهای پردازش موازی و معماری مقیاسپذیر، امکان اجرای کارآمد تحلیل دادههای حجیم را بر روی سختافزارهای ارزانقیمت فراهم میکند و یکی از ستونهای اصلی اکوسیستم Big Data بهشمار میرود.

Apache Hadoop چیست؟

Apache Hadoop مجموعهای از ابزارها و فناوریهای منبعباز است که برای پردازش و ذخیرهسازی دادههای حجیم طراحی شده است. این چارچوب با استفاده از سیستم فایل توزیعشده خود (HDFS) و الگوریتم پردازش موازی MapReduce، دادهها را به بخشهای کوچکتر تقسیم کرده و روی چندین سرور بهطور همزمان پردازش میکند. نتیجه این طراحی، افزایش سرعت پردازش و کاهش هزینههای زیرساختی در پروژههای دادهمحور است.

در عمل Hadoop به کسبوکارها و سازمانها امکان میدهد دادههای ساختیافته و غیرساختیافته خود را بدون وابستگی به سرورهای قدرتمند مرکزی، در مقیاس چندین ترابایت یا پتابایت مدیریت کنند. توسعهپذیری آسان، پشتیبانی قوی از سختافزار متنوع و وجود اکوسیستم غنی از ابزارهای مکمل، هدوپ را به انتخابی محبوب برای تحلیل دادههای بزرگ، یادگیری ماشینی و ذخیرهسازی بلندمدت اطلاعات تبدیل کرده است.

تاریخچه و پیدایش Apache Hadoop

پروژه آپاچی هدوپ در اواسط دهه ۲۰۰۰ میلادی توسط دوگ کاتینگ و مایک کافارلا آغاز شد، در پاسخ به چالش ذخیرهسازی و پردازش حجم بسیار بالای دادهها در اینترنت. الهام اصلی این پروژه از مقالههای تحقیقاتی گوگل درباره Google File System (GFS) و الگوریتم MapReduce به دست آمد که روشی نوین برای مدیریت دادههای توزیعشده معرفی میکرد. هدوپ ابتدا بخشی از پروژه موتور جستجوی منبعباز Nutch بود و سپس بهعنوان یک پروژه مستقل تحت نظارت بنیاد آپاچی توسعه یافت.

در سالهای بعد با رشد سریع Big Data هدوپ بهسرعت جایگاه خود را بهعنوان یکی از مهمترین ابزارهای تحلیل و پردازش داده پیدا کرد. شرکتهای بزرگی مانند یاهو، فیسبوک و توییتر از هدوپ برای مدیریت دادههای خود استفاده کردند. انتشار نسخههای پایدار، اضافه شدن ماژولهای تکمیلی نظیر YARN و گسترش اکوسیستم ابزارهای مرتبط، باعث شد هدوپ به یک چارچوب استاندارد در حوزه پردازش توزیعشده و ذخیرهسازی مقیاسپذیر بدل شود.

معماری و اجزای اصلی Hadoop

Hadoop Distributed File System (HDFS)

HDFS قلب معماری هدوپ است و بهصورت یک سیستم فایل توزیعشده طراحی شده تا دادهها را در قطعات کوچک (بلوکها) بین چندین سرور ذخیره کند. این ساختار باعث میشود دادهها بهصورت افزونگی (Replication) نگهداری شوند و در صورت خرابی یک سرور، اطلاعات بدون از بین رفتن قابل دسترسی باشند. HDFS ظرفیت ذخیرهسازی مقیاسپذیر را با استفاده از سختافزارهای ارزانقیمت امکانپذیر میکند.

MapReduce

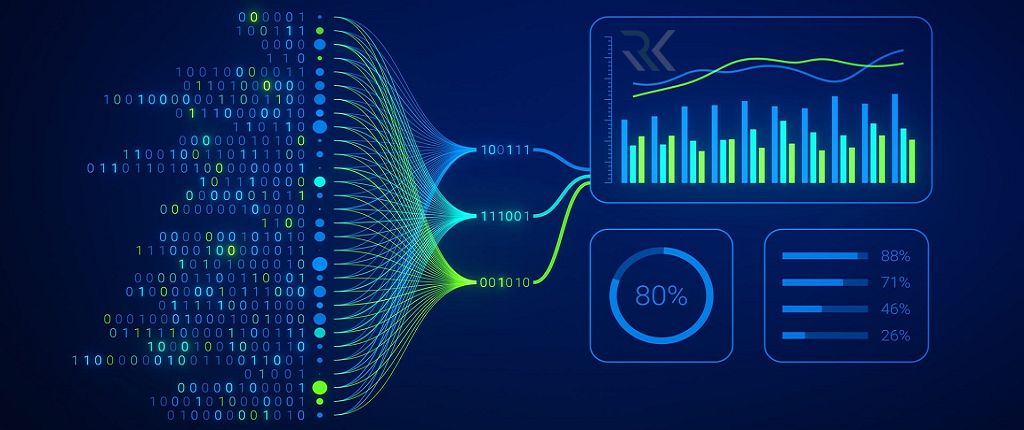

MapReduce یک مدل برنامهنویسی توزیعشده است که وظیفه پردازش دادهها را برعهده دارد. این MapReduceمدل دادهها را به بخشهای کوچکتر تقسیم میکند (Map) و سپس نتایج پردازش این بخشها را ترکیب کرده و خروجی نهایی را تولید مینماید (Reduce). به لطف این رویکرد، پردازش حجم عظیم داده بهصورت موازی و بر روی چندین گره بهطور همزمان انجام میشود.

YARN (Yet Another Resource Negotiator)

YARN لایه مدیریت منابع هدوپ است که وظیفه تخصیص منابع (CPU، حافظه، دیسک) به برنامهها و پردازشها را بر عهده دارد. این ماژول امکان اجرای چندین اپلیکیشن را روی خوشه هدوپ فراهم میکند و با مدیریت هوشمند منابع، کارایی سیستم را به شکل قابل توجهی افزایش میدهد.

Common Utilities

بخش Common Utilities مجموعهای از کتابخانهها و ابزارهای مشترک بین تمام ماژولهای هدوپ است. این کتابخانهها شامل APIهای ورودی/خروجی، ابزارهای پیکربندی سیستم و بستههای امنیتی هستند که توسعه و اجرای برنامههای مبتنی بر هدوپ را سادهتر میکنند. وجود این کامپوننتها باعث هماهنگی بهتر بین بخشهای مختلف چارچوب میشود.

اکوسیستم و ابزارهای مهم Hadoop

Hive

Hive یک سیستم انبار داده (Data Warehouse) مبتنی بر هدوپ است که امکان کار با دادهها بهوسیله زبان HiveQL مشابه SQL را فراهم میکند. این ابزار برای تحلیل دادههای ذخیرهشده در HDFS طراحی شده و با ترجمه پرسوجوهای کاربر به اجرای MapReduce، تحلیلهای پیچیده را بهصورت ساده و قابل فهم برای متخصصان پایگاهداده انجام میدهد.

Pig

Pig یک پلتفرم پردازش داده با زبان اسکریپتنویسی Pig Latin است که فرآیند توسعه Jobهای MapReduce را سادهتر میکند. با Pig میتوان دادههای نیمهساختیافته یا غیرساختیافته را با کدنویسی کوتاه و قابلخواندن پردازش و تبدیل کرد، بدون نیاز به نوشتن کدهای جاوا پیچیده.

HBase

HBase یک پایگاهداده NoSQL ستونمحور است که روی HDFS اجرا میشود و برای ذخیرهسازی و بازیابی دادههای حجیم با دسترسی تصادفی بهینه شده است. این ابزار مناسب محیطهایی است که نیاز به ذخیرهسازی دادههای بسیار بزرگ همراه با سرعت بالای خواندن و نوشتن دارند.

Sqoop

Sqoop ابزاری برای انتقال داده بین پایگاههایداده رابطهای (مانند MySQL، PostgreSQL) و هدوپ است. این ابزار دادهها را از سیستمهای سنتی استخراج کرده و به HDFS وارد میکند، یا برعکس، داده پردازششده در هدوپ را به پایگاهدادههای رابطهای بازمیگرداند.

Flume

Flume یک ابزار جمعآوری، انتقال و ذخیرهسازی دادههای حجیم بهخصوص دادههای لاگ است. این ابزار دادهها را از منابع مختلف مانند وبسرورها یا سیستمهای امنیتی جمع کرده و با بهرهگیری از معماری توزیعشده، آنها را به HDFS یا دیگر مخازن داده منتقل میکند.

Zookeeper

Zookeeper یک سرویس هماهنگکننده برای مدیریت پیکربندی، همگامسازی (Synchronization) و نامگذاری در خوشههای توزیعشده است. بسیاری از اجزای هدوپ برای عملکرد پایدار و هماهنگ، از Zookeeper برای مدیریت وضعیت و سرویسهای خود استفاده میکنند.

تفاوت Hadoop با Apache Spark

در حالیکه آپاچی هدوپ و آپاچی اسپارک هر دو برای پردازش دادههای عظیم طراحی شدهاند، اما فلسفه و روش عملکرد آنها تفاوت اساسی دارد. هدوپ بر پایه مدل MapReduce عمل میکند که هر بار دادهها را از دیسک میخواند و نتایج را روی دیسک ذخیره میکند، در نتیجه پردازش آن عمدتاً دیسکمحور (Disk-Based) است. این ساختار در پروژههایی که بیش از چند مرحله پردازش پیوسته ندارند، کارآمد است؛ اما در پروژههایی با تکرار زیاد عملیات یا تحلیلهای در حافظه، باعث کندی میشود.

از سوی دیگر، Apache Spark با تمرکز بر پردازش در حافظه (In-Memory Computing) طراحی شده و میتواند دادهها را بدون نوشتن مکرر روی دیسک تحلیل کند، و همین امر آن را تا چندین برابر سریعتر از Hadoop MapReduce میکند. Spark همچنین پشتیبانی وسیعی از ابزارهای هوش مصنوعی، یادگیری ماشین، تحلیل جریان داده (Streaming) و SQL دارد. در واقع، Spark را میتوان نسل دوم از فناوریهای پردازش دادههای عظیم دانست که بهصورت کامل با فضای ابری و ابزارهای زنجیره داده سازگار است.

ویژگیها / مقایسه |

Apache Hadoop |

Apache Spark |

|---|---|---|

|

مدل پردازش اصلی |

مبتنی بر MapReduce |

پردازش در حافظه (In-Memory) |

|

سرعت اجرا |

کندتر (به دلیل عملیات بر پایه دیسک) |

سریعتر (بهدلیل محاسبات در RAM) |

|

ذخیرهسازی دادهها |

HDFS (Hadoop File System) |

میتواند از HDFS، S3 یا دیگر منابع استفاده کند |

|

پشتیبانی از Streaming |

محدود و غیربلادرنگ |

پشتیبانی کامل از Stream پردازش زنده |

|

زبانهای برنامهنویسی |

Java, Python |

Scala, Java, Python, R |

|

یادگیری ماشینی (ML) |

نیاز به ابزارهای فرعی |

دارای کتابخانه MLlib داخلی |

|

منابع مصرفی |

وابسته به دیسک و CPU |

بهینهتر با استفاده از حافظه RAM |

|

سادگی توسعه |

پیچیدگی بالاتر در کدنویسی MapReduce |

رابط سطحبالا و آسان برای توسعه |

|

پشتیبانی از SQL |

توسط Hive یا ابزارهای خارجی |

دارای Spark SQL داخلی |

|

موارد استفاده رایج |

پشتیبان ذخیرهسازی و پردازش آفلاین |

تحلیل بلادرنگ، یادگیری ماشین، هوش دادهمحور |

هدوپ در کدام موارد کاربرد دارد؟

- تحلیل دادههای عظیم (Big Data Analytics)

- ذخیرهسازی دادههای حجیم در مقیاس پتابایت

- پردازش دادههای IoT

- سیستمهای توصیهگر (Recommendation Systems)

- تحلیل لاگهای سیستم و امنیت سایبری

- دادهکاوی و یادگیری ماشینی

- پردازش جریان داده (Stream Processing)

- تجزیهوتحلیل بازار و رفتار مشتری

جمعبندی…

آپاچی هدوپ بهعنوان یکی از ستونهای اصلی فناوری Big Data، توانسته با معماری توزیعشده و اکوسیستم قدرتمند خود، راهکارهای مقیاسپذیر و مقرونبهصرفهای برای ذخیرهسازی و پردازش دادههای عظیم ارائه دهد. ترکیب قابلیتهای HDFS، MapReduce و ابزارهای مکمل، هدوپ را به بستری انعطافپذیر برای تحلیل دادهها در حوزههای گوناگون از IoT تا یادگیری ماشینی تبدیل کرده است.

سؤالات متداول

هدوپ یک چارچوب متنباز برای ذخیرهسازی و پردازش دادههای حجیم بهصورت توزیعشده و موازی است که توسط Apache توسعه یافته است.

بله، هدوپ کاملاً رایگان و متنباز بوده و توسط جامعه بزرگ توسعهدهندگان و بنیاد Apache پشتیبانی میشود.

هدوپ بهصورت بومی برای لینوکس طراحی شده، اما امکان اجرای آن روی ویندوز یا سیستمعاملهای دیگر با پیکربندی مناسب وجود دارد.

HDFS یک سیستم فایل توزیعشده است که دادهها را در بلوکهای متعدد بین نودها ذخیره و با افزونگی امنیت آنها را تضمین میکند.

خیر، هدوپ برای پردازش دادههای حجیم طراحی شده و استفاده از آن برای دادههای کمحجم معمولاً مقرونبهصرفه نیست.

تحلیل دادههای عظیم، پردازش IoT، سیستمهای توصیهگر، تحلیل امنیتی و یادگیری ماشین از مهمترین کاربردهای آن هستند.

موارد اخیر

-

سیستمهای توزیعشده (Distributed System) چیستند و چه تفاوتی با سیستمهای متمرکز دارند؟

سیستمهای توزیعشده (Distributed System) چیستند و چه تفاوتی با سیستمهای متمرکز دارند؟ -

Ceph چیست و معماری آن چگونه است؟ مقایسه Ceph با سایر سیستمهای ذخیره سازی

Ceph چیست و معماری آن چگونه است؟ مقایسه Ceph با سایر سیستمهای ذخیره سازی -

هرآنچه باید درباره Proxmox VE بدانید + راهنمای جامع نصب و پیکربندیProxmox در لینوکس

هرآنچه باید درباره Proxmox VE بدانید + راهنمای جامع نصب و پیکربندیProxmox در لینوکس -

مجازیساز KVM چیست و چه تفاوتی با VMware Workstation دارد؟

مجازیساز KVM چیست و چه تفاوتی با VMware Workstation دارد؟ -

فرایند یکپارچه رشنال (RUP) چیست و چگونه توسعه نرمافزار را مدیریت میکند؟

فرایند یکپارچه رشنال (RUP) چیست و چگونه توسعه نرمافزار را مدیریت میکند؟ -

مدل مارپیچ (Spiral Model) چیست و چگونه در توسعه نرمافزار کمک میکند؟

مدل مارپیچ (Spiral Model) چیست و چگونه در توسعه نرمافزار کمک میکند؟ -

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟ -

توسعه سریع نرمافزار (RAD) چیست و کجا کاربرد دارد؟

توسعه سریع نرمافزار (RAD) چیست و کجا کاربرد دارد؟ -

تست یکپارچهسازی (Integration Testing) چیست و چه کاربردی در توسعه نرمافزار دارد؟

تست یکپارچهسازی (Integration Testing) چیست و چه کاربردی در توسعه نرمافزار دارد؟ -

Agile چیست؟ معرفی متدولوژی توسعه نرمافزار اجایل

Agile چیست؟ معرفی متدولوژی توسعه نرمافزار اجایل

برترین ها

-

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟ -

اوکتا (Okta) چیست و چه کاربردی در امنیت سازمانها دارد؟

اوکتا (Okta) چیست و چه کاربردی در امنیت سازمانها دارد؟ -

چرخه عمر توسعه نرمافزار (SDLC) چیست و چرا در مهندسی نرمافزار اهمیت دارد؟

چرخه عمر توسعه نرمافزار (SDLC) چیست و چرا در مهندسی نرمافزار اهمیت دارد؟ -

چکلیست امنیتی و تحلیل تخصصی آسیبپذیری های جدی محصولات مایکروسافت تا نوامبر 2025

چکلیست امنیتی و تحلیل تخصصی آسیبپذیری های جدی محصولات مایکروسافت تا نوامبر 2025 -

مدلسازی تهدید (Threat Modeling) چیست و چه کاربردی در امنیت سایبری دارد؟

مدلسازی تهدید (Threat Modeling) چیست و چه کاربردی در امنیت سایبری دارد؟

اشتراک گذاری این مطلب

دیدگاهتان را بنویسید

نشانی ایمیل شما منتشر نخواهد شد. بخشهای موردنیاز علامتگذاری شدهاند *