آپاچی اسپارک (Apache Spark) چیست و چگونه نصب میشود؟

حجم دادهها با سرعتی سرسامآور رشد میکند و نیاز به ابزارهایی برای پردازش سریع و مقیاسپذیر بیش از هر زمان دیگری احساس میشود. Apache Spark یکی از محبوبترین فریمورکهای پردازش داده در مقیاس بزرگ است که توانسته با سرعت بالا و سادگی کار، جایگزینی مؤثر برای مدل سنتی MapReduce در اکوسیستم هدوپ شود. اسپارک با پشتیبانی از زبانهای محبوبی چون Python، Java و R، بستری قدرتمند برای تحلیل داده، یادگیری ماشین و پردازش بلادرنگ فراهم کرده است.

Apache Hadoop (هدوپ) چیست و چه کاربردهایی دارد؟ + مقایسه با Apache Spark

آپاچی اسپارک (Apache Spark) چیست؟

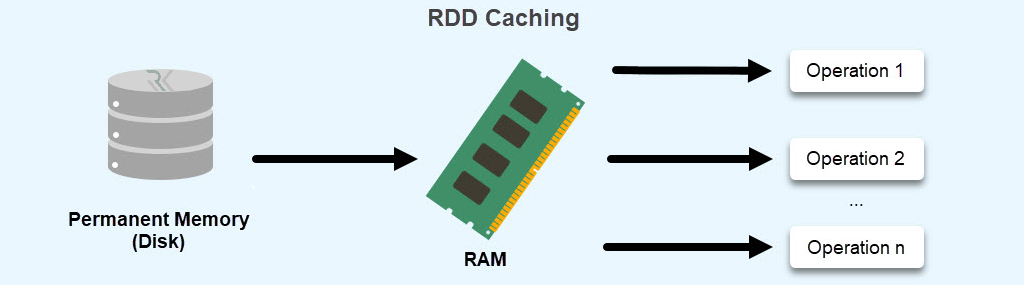

آپاچی اسپارک، چارچوبی متنباز برای پردازش دادههای توزیعشده است که در سال ۲۰۰۹ توسط آزمایشگاه AMPLab در دانشگاه کالیفرنیا، برکلی ایجاد و بعدها به پروژهای رسمی در بنیاد Apache Software Foundation تبدیل شد. هدف اصلی اسپارک، افزایش سرعت و کاهش پیچیدگی در پردازش دادههای عظیم بود؛ به همین دلیل از مدل پردازش In‑Memory (در حافظه) استفاده میکند که اجرای وظایف را چندین برابر سریعتر از Hadoop MapReduce ممکن میسازد.

از دیگر ویژگیهای مهم Apache Spark انعطافپذیری بالای آن در کار با منابع داده مختلف است؛ از فایلهای موجود در HDFS و Amazon S3 گرفته تا پایگاههای داده سنتی و استریمهای زنده. این فریمورک قابلیت اجرای الگوریتمهای تحلیلی پیچیده، آموزش مدلهای یادگیری ماشین، تحلیل گراف و پردازش دادههای ساختیافته و غیرساختیافته را در یک بستر یکپارچه ارائه میدهد. اسپارک امروزه به یکی از ابزارهای کلیدی در Big Data Analytics و زیرساختهای هوش مصنوعی تبدیل شده است.

تاریخچه Apache Spark

پروژه Apache Spark نخستینبار در سال ۲۰۰۹ توسط گروه AMPLab دانشگاه کالیفرنیا، برکلی آغاز شد. هدف اصلی آن، رفع محدودیتهای Hadoop MapReduce در زمینه سرعت پردازش و کار با دادههای تکرارشونده (Iterative Processing) بود. این پروژه با طراحی یک موتور پردازشی مبتنی بر حافظه (In‑Memory Processing) توانست سرعت اجرای الگوریتمهای یادگیری ماشین و تجزیهوتحلیل داده را تا چندین برابر افزایش دهد. در سال ۲۰۱۰، کد منبع اسپارک بهصورت آزاد منتشر شد و مورد استقبال گستردهٔ جامعهٔ داده قرار گرفت.

در سال ۲۰۱۳ بنیاد Apache Software Foundation رسماً پروژه را پذیرفت و بهعنوان محصولی متنباز با همکاری صدها شرکت فناوری (ازجمله Databricks، IBM و Cloudera) توسعه یافت. از آن زمان تاکنون، Apache Spark به یکی از مهمترین بسترهای پردازش دادهٔ حجیم در جهان تبدیل شده است. نسخههای بعدی اسپارک امکاناتی مانند Spark SQL، Streaming و MLlib را معرفی کردند که آن را به بستری جامع برای تحلیل دادههای ساختیافته و زنده، آموزش مدلهای یادگیری ماشین و حتی پردازش گراف تبدیل کردهاند.

معماری و اجزای اصلی آپاچی اسپارک

Driver Program.1

Driver قلب عملیاتی اسپارک است که منطق برنامهٔ کاربر را اجرا کرده و مسئول تبدیل کد به مجموعهای از Taskها است. این مؤلفه وظیفه دارد برنامهٔ کاربر را تجزیه کرده و آن را در قالب DAG (Directed Acyclic Graph) به مراحل قابلاجرا تقسیم کند. سپس این وظایف را برای اجرای موازی میان نودهای خوشه توزیع میکند. Driver همچنین وضعیت اجرای Jobها را مانیتور کرده و گزارشها را در کنسول یا UI وب اسپارک نمایش میدهد.

2. Cluster Manager

Cluster Manager سرویس مدیریتی است که منابع سختافزاری (CPU، حافظه و نودهای شبکه) را بین برنامههای مختلف اسپارک تخصیص میدهد. اسپارک میتواند روی چند نوع مدیریتکننده اجرا شود: Standalone Mode (داخلی اسپارک)، YARN در Hadoop و Apache Mesos برای محیطهای اشتراکی بزرگتر. این مؤلفه انعطافپذیری بالایی برای اجرای اسپارک در زیرساختهای گوناگون از جمله Cloud فراهم میکند.

3. Executors

Executorها فرآیندهایی هستند که در هر نود از خوشه اجرا میشوند و وظیفهٔ واقعی پردازش داده را برعهده دارند. هر Executor دادهها را از منابع تعیینشده دریافت کرده، عملیات مربوط به Taskها را انجام داده و نتایج را به Driver بازمیگرداند. آنها همچنین دادههای موردنیاز را بهصورت Cache یا In‑Memory Storage در حافظه نگهداری میکنند تا اجرای تکرارشونده وظایف سریعتر انجام شود.

4. RDD (Resilient Distributed Dataset)

RDD ساختار دادهی بنیادی در اسپارک است که یک مجموعه توزیعشده از اشیا را نشان میدهد. دادهها در قالب پارتیشنهای متعدد میان نودها توزیع شدهاند. ویژگی کلیدی RDD در قابلیت Fault Tolerance است؛ یعنی در صورت خرابی یک نود، دادهها بهطور خودکار از خطا بازیابی میشوند. RDDها امکان اعمال عملیات تحلیلی مانند Map، Filter و Reduce را بهصورت موازی فراهم میکنند و پایه اکثر ماژولهای اسپارک محسوب میشوند.

5. SparkContext

SparkContext بهمنزله نقطه ورود (Entry Point) برنامه است و ارتباط بین برنامه کاربر و خوشه اسپارک را برقرار میکند. این مؤلفه منابع موردنیاز را از Cluster Manager درخواست کرده و محیط اجرای Job را آماده میسازد. از طریق SparkContext میتوان RDD ایجاد کرد، داده بارگذاری نمود و عملیات تحلیلی را آغاز کرد. در نسخههای جدیدتر، SparkSession جایگزین آن شده که رابطی سادهتر و جامعتر برای استفاده از تمام ماژولهای اسپارک (SQL، Streaming، MLlib و غیره) ارائه میدهد.

اکوسیستم و ماژولهای کلیدی Apache Spark

آپـاچی اسپـارک صرفاً یک موتور پردازش داده نیست، بلکه یک اکوسیستم جامع تحلیلی است که از چندین ماژول کلیدی تشکیل شده و هر کدام برای نوعی خاص از پردازش داده طراحی شدهاند.

Spark SQL

ماژول Spark SQL امکان پردازش دادههای ساختیافته را با استفاده از زبان SQL یا DataFrame API فراهم میکند. این ماژول پلی میان دنیای تحلیل سنتی پایگاهدادهها و پردازش توزیعشده است. با Spark SQL میتوان دادهها را از منابعی مثل HDFS، Hive، Parquet، JSON و JDBC خواند و کوئریهای تحلیلی پیشرفته را روی آنها اجرا کرد. همچنین این ماژول قابلیت Optimized Query Execution دارد که کارایی پرسوجوها را بهصورت خودکار بهینه میکند.

Spark Streaming

این ماژول برای پردازش دادههای بلادرنگ (Real‑Time Processing) طراحی شده است. Spark Streaming دادههایی را که بهصورت پیوسته از منابعی مثل Kafka، Flume یا Socket دریافت میشوند، به Batchهای کوچک زمانی تقسیم کرده و بهسرعت تحلیل میکند. به کمک آن میتوان داشبوردهای لحظهای، سامانههای مانیتورینگ امنیتی یا سیستمهای تشخیص ناهنجاری در جریان دادهها ساخت. نسخه جدیدتر آن Structured Streaming انعطاف و پایداری بیشتری دارد.

MLlib (Machine Learning Library)

کتابخانه MLlib مجموعهای از الگوریتمها و ابزارهای یادگیری ماشین را در اختیار کاربر قرار میدهد؛ از دستهبندی (Classification) و خوشهبندی (Clustering) گرفته تا رگرسیون و کاهش ابعاد (Dimensionality Reduction). این ماژول به لطف پردازش حافظهای اسپارک، آموزش مدلها را سریعتر از چارچوبهای سنتی انجام میدهد و از قابلیت Pipelineهای یادگیری ماشینی برای سادهسازی فرآیند آموزش و ارزیابی پشتیبانی میکند.

GraphX

GraphX ابزار تخصصی اسپارک برای تحلیل گرافها و شبکهها است. این ماژول دادهها را بهصورت رأس (Vertex) و یال (Edge) مدل کرده و عملیاتهایی نظیر یافتن مسیرهای کوتاه، تشخیص اجتماعات و تحلیل ارتباطات شبکهای را ارائه میدهد. GraphX با استفاده از RDDهای خاص گرافی، پردازشهای توزیعشده را بر روی شبکههای بسیار بزرگ ممکن میسازد.

SparkR و PySpark

این دو رابط کاربری امکان استفاده از قابلیتهای اسپارک را از زبانهای R و Python فراهم میسازند. PySpark از محبوبترین ابزارهای دادهکاوان پایتونی شناخته میشود که حتی با کتابخانههایی مانند Pandas و NumPy نیز قابلادغام است. SparkR نیز برای متخصصان دادهای که با محیط آماری R کار میکنند، راهی برای اجرای محاسبات حجیم روی خوشه فراهم میکند بیآنکه نیاز باشد با معماری درونی اسپارک درگیر شوند.

مزایا و معایب Apache Spark

مزایا |

معایب |

|---|---|

|

سرعت پردازش بسیار بالا بهدلیل In‑Memory Computation |

مصرف زیاد حافظه (RAM) |

|

پشتیبانی از زبانهای برنامهنویسی متعدد (Python، Java، Scala، R) |

پیچیدگی در تنظیم، پیکربندی و مانیتورینگ خوشهها |

|

پردازش بلادرنگ دادهها با Spark Streaming |

وابستگی نسبی به JVM در برخی محیطها |

|

یکپارچگی کامل ماژولها (SQL، MLlib، GraphX، Streaming) |

کارایی پایین در حجم داده کوچک |

|

سازگاری با پلتفرمهای YARN، Mesos، Kubernetes |

آموزش نصب و راهاندازی Apache Spark روی لینوکس

1. بهروزرسانی سیستم و نصب پیشنیازها

در ابتدا مخازن سیستم را آپدیت کرده و Java (نسخه ۸ یا بالاتر) را نصب کنید، چون Spark به JVM نیاز دارد.

sudo apt update && sudo apt upgrade -y

sudo apt install openjdk-11-jdk -y

سپس مسیر نصب Java را بررسی کنید:

java -version

readlink -f $(which java)

در صورت نیاز، در فایل ~/.bashrc مقدار JAVA_HOME را اضافه کنید:

export JAVA_HOME=/usr/lib/jvm/java-11-openjdk-amd64

export PATH=$PATH:$JAVA_HOME/bin

و سپس Bash را دوباره بارگذاری کنید:

source ~/.bashrc

2. نصب Apache Spark

ابتدا آخرین نسخه پایدار اسپارک را از سایت رسمی (یا با wget) دریافت کنید. در این مثال از نسخه ۳.۵.۰ استفاده شده است:

cd /opt

sudo wget https://downloads.apache.org/spark/spark-3.5.0/spark-3.5.0-bin-hadoop3.tgz

sudo tar -xvf spark-3.5.0-bin-hadoop3.tgz

sudo mv spark-3.5.0-bin-hadoop3 /opt/spark

3. اجرای Spark در حالت محلی (Standalone Mode)

اکنون میتوانید اسپارک را بهصورت مستقل و محلی اجرا کنید:

start-master.sh

در خروجی ترمینال آدرسی مشابه زیر نمایش داده میشود:

Spark Master Web UI available at http://localhost:8080

سپس برای افزودن یک Worker:

start-worker.sh spark://localhost:7077

اکنون در مرورگر خود آدرس http://localhost:8080 را باز کنید تا رابط مدیریتی اسپارک را ببینید (شامل وضعیت Master و Workerها).

4. اجرای رابط تعاملی (Spark Shell یا PySpark)

برای اجرای محیط تعاملی اسپارک با Scala یا Python از دستورات زیر استفاده کنید:

Scala Shell:

spark-shell

PySpark (برای Python):

pyspark

پس از اجرا پیغام خوشآمدگویی و نسخه Spark را مشاهده میکنید. اکنون میتوانید دستورات تحلیلی خود را مستقیماً وارد کنید.

جمعبندی…

Apache Spark یکی از قدرتمندترین چارچوبهای متنباز برای پردازش دادههای عظیم است که با تکیه بر معماری In‑Memory، سرعت تحلیلی بسیار بالایی را در مقایسه با فناوریهای سنتی مانند Hadoop فراهم میکند. پشتیبانی از زبانهای چندگانه، یکپارچگی با ماژولهایی چون SQL، MLlib، Streaming و GraphX و سازگاری با محیطهای گوناگون چابکی و مقیاسپذیری منحصربهفردی به آن بخشیده است. بههمیندلیل Spark امروز قلب بسیاری از سامانههای هوش تجاری، یادگیری ماشین و تحلیل بلادرنگ داده در مقیاس سازمانی است.

سوالت متداول

چارچوبی متنباز برای پردازش توزیعشدهی دادههای حجیم است که با استفاده از حافظه (In‑Memory Computation) سرعت پردازش را چندین برابر افزایش میدهد.

Spark دادهها را در حافظه RAM نگه میدارد، درحالیکه Hadoop برای هر مرحله به دیسک مراجعه میکند؛ بنابراین Spark تا صد برابر سریعتر است و از جریانهای بلادرنگ پشتیبانی میکند.

خیر. Spark میتواند بهصورت مستقل (Standalone) اجرا شود، اما میتواند در صورت تمایل بر روی YARN یا HDFS نیز قرار گیرد.

Python (PySpark)، Scala، Java و R از مهمترین زبانهای توسعه در Spark هستند.

بله، MLlib مجموعه الگوریتمها و ابزارهای آموزش، ارزیابی و پیادهسازی مدلهای یادگیری ماشین را بهصورت توزیعشده ارائه میدهد.

موارد اخیر

-

آپاچی اسپارک (Apache Spark) چیست و چگونه نصب میشود؟

آپاچی اسپارک (Apache Spark) چیست و چگونه نصب میشود؟ -

Apache Hadoop (هدوپ) چیست و چه کاربردهایی دارد؟ + مقایسه با Apache Spark

Apache Hadoop (هدوپ) چیست و چه کاربردهایی دارد؟ + مقایسه با Apache Spark -

سیستمهای توزیعشده (Distributed System) چیستند و چه تفاوتی با سیستمهای متمرکز دارند؟

سیستمهای توزیعشده (Distributed System) چیستند و چه تفاوتی با سیستمهای متمرکز دارند؟ -

Ceph چیست و معماری آن چگونه است؟ مقایسه Ceph با سایر سیستمهای ذخیره سازی

Ceph چیست و معماری آن چگونه است؟ مقایسه Ceph با سایر سیستمهای ذخیره سازی -

هرآنچه باید درباره Proxmox VE بدانید + راهنمای جامع نصب و پیکربندیProxmox در لینوکس

هرآنچه باید درباره Proxmox VE بدانید + راهنمای جامع نصب و پیکربندیProxmox در لینوکس -

مجازیساز KVM چیست و چه تفاوتی با VMware Workstation دارد؟

مجازیساز KVM چیست و چه تفاوتی با VMware Workstation دارد؟ -

فرایند یکپارچه رشنال (RUP) چیست و چگونه توسعه نرمافزار را مدیریت میکند؟

فرایند یکپارچه رشنال (RUP) چیست و چگونه توسعه نرمافزار را مدیریت میکند؟ -

مدل مارپیچ (Spiral Model) چیست و چگونه در توسعه نرمافزار کمک میکند؟

مدل مارپیچ (Spiral Model) چیست و چگونه در توسعه نرمافزار کمک میکند؟ -

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟ -

توسعه سریع نرمافزار (RAD) چیست و کجا کاربرد دارد؟

توسعه سریع نرمافزار (RAD) چیست و کجا کاربرد دارد؟

برترین ها

-

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟

Out of Band Management (OOB) چیست و چرا برای امنیت شبکه حیاتی است؟ -

اوکتا (Okta) چیست و چه کاربردی در امنیت سازمانها دارد؟

اوکتا (Okta) چیست و چه کاربردی در امنیت سازمانها دارد؟ -

چرخه عمر توسعه نرمافزار (SDLC) چیست و چرا در مهندسی نرمافزار اهمیت دارد؟

چرخه عمر توسعه نرمافزار (SDLC) چیست و چرا در مهندسی نرمافزار اهمیت دارد؟ -

چکلیست امنیتی و تحلیل تخصصی آسیبپذیری های جدی محصولات مایکروسافت تا نوامبر 2025

چکلیست امنیتی و تحلیل تخصصی آسیبپذیری های جدی محصولات مایکروسافت تا نوامبر 2025 -

مدلسازی تهدید (Threat Modeling) چیست و چه کاربردی در امنیت سایبری دارد؟

مدلسازی تهدید (Threat Modeling) چیست و چه کاربردی در امنیت سایبری دارد؟

اشتراک گذاری این مطلب

دیدگاهتان را بنویسید

نشانی ایمیل شما منتشر نخواهد شد. بخشهای موردنیاز علامتگذاری شدهاند *